“本来我是拒绝的,但AI实在是太火了!”

Ai爆火,需要的GPU算力剧增

今年,这Ai真的是太火爆了,不管是做啥的只要沾上GPT,那流量都是嗷嗷的。这不是么,我这边本想部署几个比较流行的应用,嘿!算力不够啊~

我们都知道GPU的核数远超CPU,被称为众核,每个核拥有的缓存大小相对小,数字逻辑运算单元也少而简单,从结果上导致CPU擅长处理具有复杂计算步骤和复杂数据依赖的计算任务,而GPU适合对大量数据进行并行的简单计算,正好Ai就需要这个。

所以么,英伟达趁机走上了巅峰!

目前开源的AI项目

微软的DeepSpeed-Chat,一个 130 亿参数的类 ChatGPT 模型,训练时间只需要 1.25 小时;

再看看下面:

GLM-10B/130B:双语(中文和英文)双向稠密模型。

OPT-2.7B/13B/30B/66B:Meta开源的预训练语言模型。

LLaMA-7B/13B/30B/65B:Meta开源的基础大语言模型。

Alpaca(LLaMA-7B):一个强大的可复现的智能跟随模型,种子任务都是英语,收集的数据也都是英文,因此训练出来的模型未对中文优化。

Alpaca-Lora:Stanford Alpaca 是在 LLaMA 整个模型上微调,而 Alpaca-Lora 则是利用 Lora 技术,在冻结原模型 LLaMA 参数的情况下,通过往模型中加入额外的网络层,并只训练这些新增的网络层参数。由于这些新增参数数量较少,这样不仅微调的成本显著下降,还能获得和全模型微调类似的效果。

BELLE(BLOOMZ-7B/LLaMA-7B):项目基于 Stanford Alpaca,针对中文做了优化,模型调优仅使用由ChatGPT生产的数据(不包含任何其他数据)。

ChatGLM-6B:中英双语的对话语言模型。

出了这些语言模型,还有 text to image训练的也就是Ai作画,我也懒得去对比了,直接给你最好的两个:

Stable Diffusion–AI 和Stable Diffusion,都可以自行部署webUI。

如果你要自行部署上面的模型,可以搜索项目名称,然后到github上看。

什么人需要GPU计算

首先,当然是搞深度学习的技术人才,深度学习和训练模型都需要大量的计算;

另外,像我这种做博客的,天天想着测试几个UI,然后做成视频吸粉的;

其实,有些人才已经在这方面做的很出色了,已经赢在了起跑线上,怎么说呢,就说这些技术大牛,整合开源的项目,用API做出了个ChatGPT多用户国内版,刚好在国内控制GPT的时候上线,当然需要付费使用,用户还不少~

另外有个行业,就是做知识付费的,早就嗅到了商机,今天我看知识星球上靠着GPT教学的课程,营收400万了,他赚钱比GPT都早半个月。

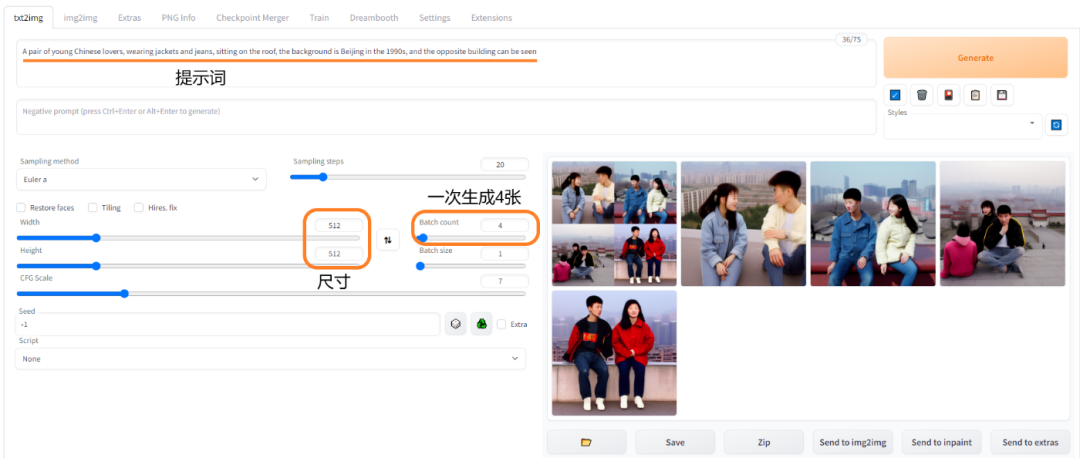

这图片是Stable Diffusion–AI生成的90年代中国情侣,这个市场也不是没有,现在训练古风的已经能做插画了,就是一个小团队运营,赚钱的机会也是大大的。

当然,训练各种模型,也包括voice-text这种,都需要GPU运算,我好像赶不上这波淘金热了,只能卖铁锹了。

哪里有GPU的服务器

为啥我推荐GPU的服务器呢,因为把项目建设在云端可供用户使用,很方便的变现;而自己的GPU电脑那只能是自嗨,不明说了,自己想。

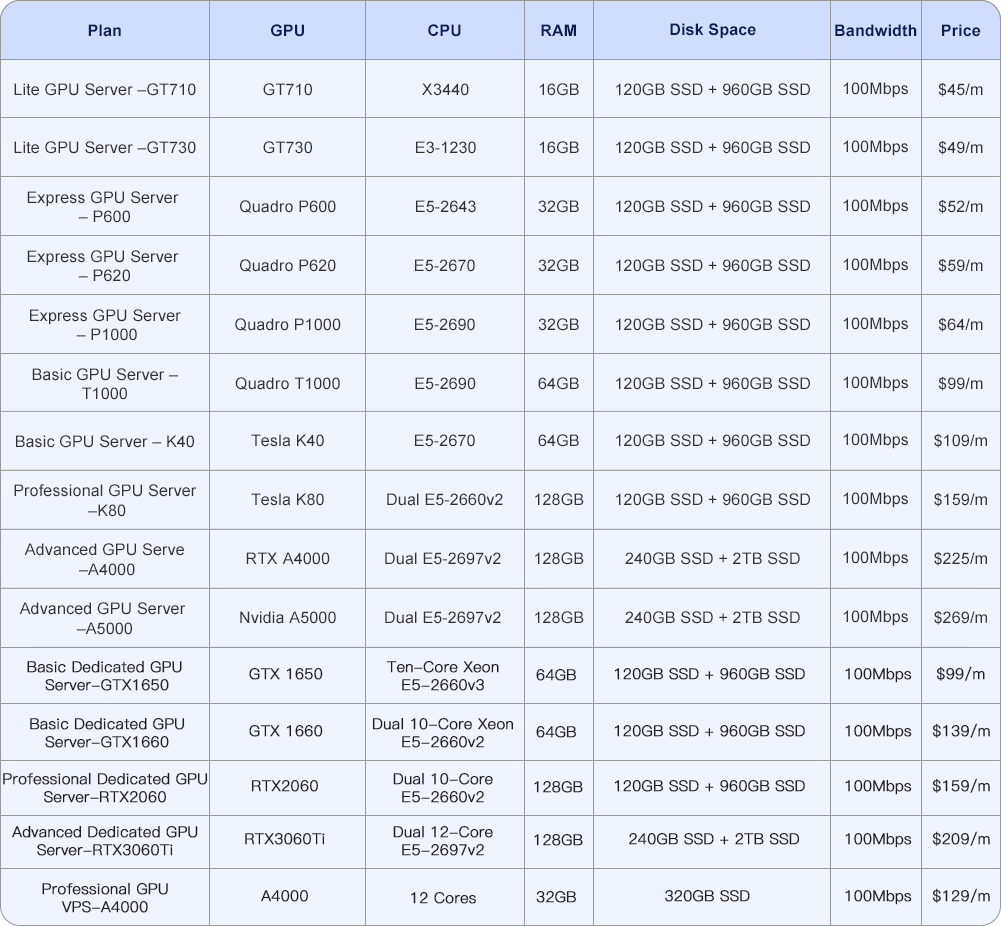

1、DatabaseMart 这家服务器商从2015年开始,口号就是“买的越久价格越低”,GPU从$45/月到$270/月,显卡从GT710到RTX3060Ti,英伟达A5000,涵盖了从2016年到现在的主流计算型显卡,配置还行价格低廉,新手建议选择这家。当然,他家的vps我就不介绍了,注册地址: https://clients.databasemart.com/aff.php?aff=1386&gid=20 下面是GPU价格目录:

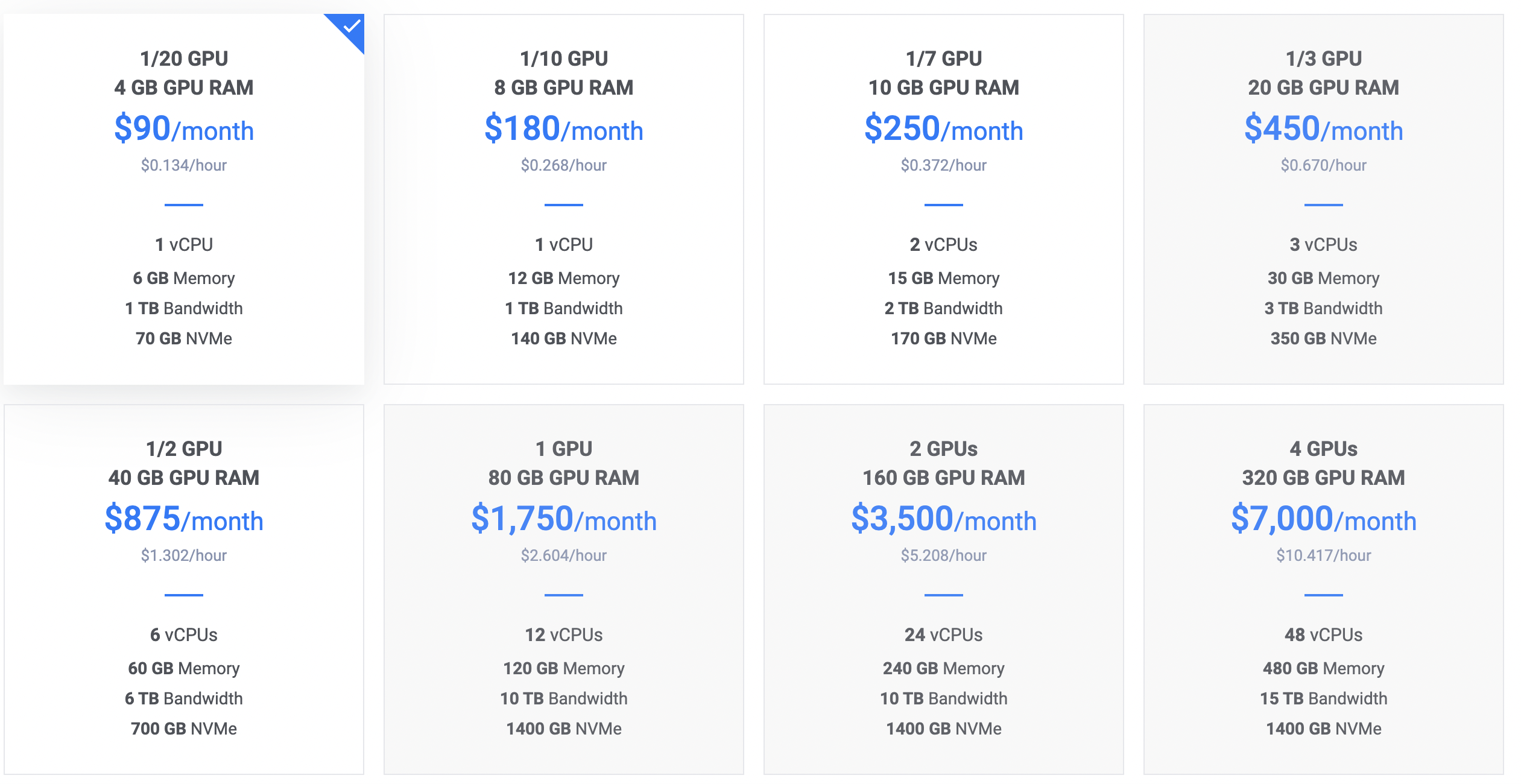

2、vultr.com 这是我接触比较早的一家,说实话IP比较烂了,推出GPU也仅有一年的时间,不过有个优势哦,可以按小时付费,如果我们仅仅是测试一个项目,用几个小时就可以删除,那么vultr是首选:

普通用户注册: https://www.vultr.com/?ref=8730332 (需充值$10)

注册送$100:https://www.vultr.com/?ref=8981484-8H (需充值$35)

上面两个链接看自己实力任意选择,也支持支付宝。

价格的话,要看你选用什么显卡,我以A100为例,如果1/3GPU够用,一个小时不到5元钱:

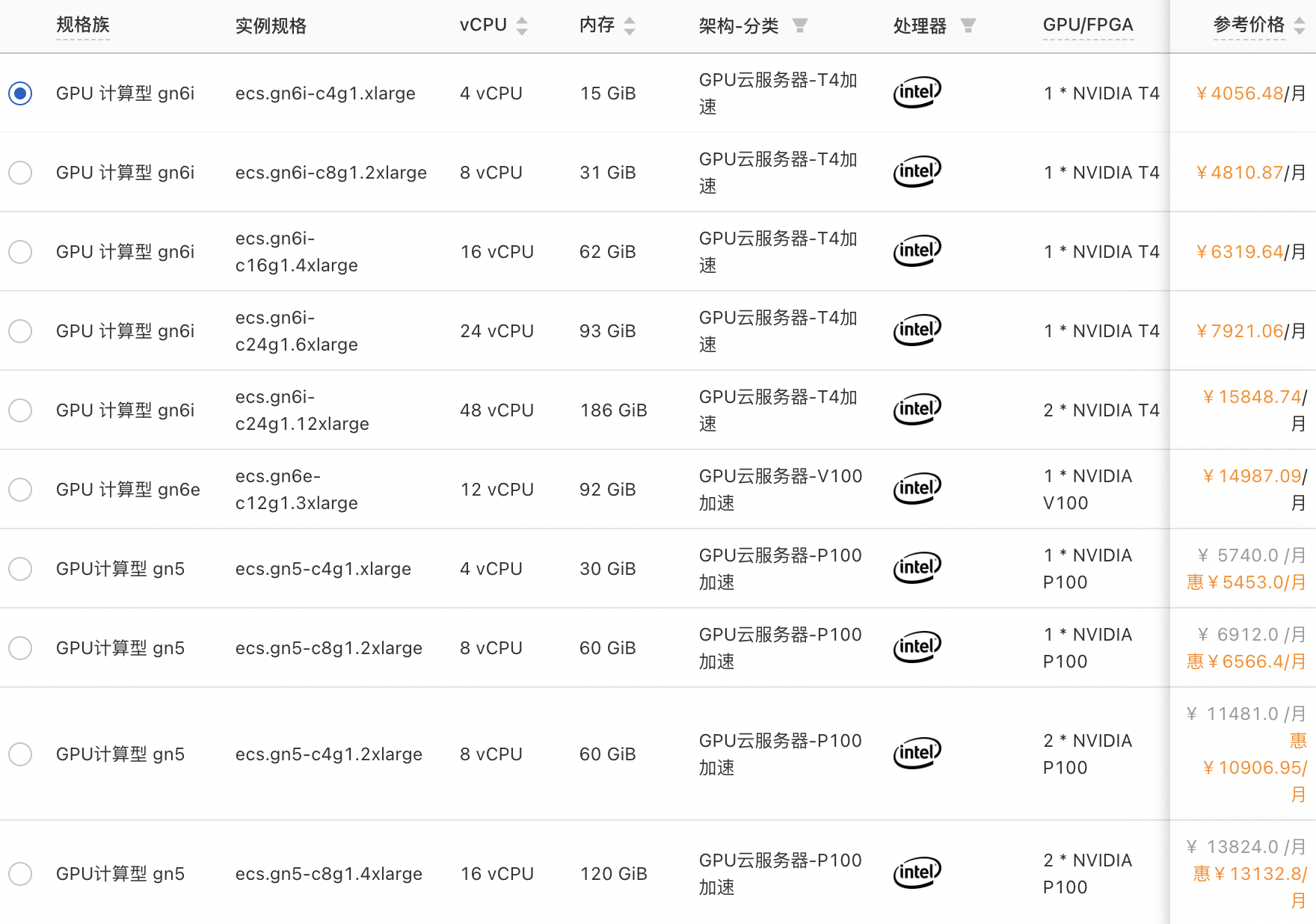

3、如果有在国内部署GPU的需求,可以试试阿里云: https://www.aliyun.com/activity/new/index?userCode=syh805zy

在上面页面注册后,购买路径:产品——云服务器ECS——定义购买——GPU计算,价格参考如下:

总结

随着Ai的继续风靡,GPU服务器可能存在水涨船高的现象,上面我找到的这几个是比价靠谱的,当然我没办法把所有GPU商家都罗列出来,更何况有的商家仅仅安装了N卡,驱动都要自己安装,那就比较耗时了。我建议大家购买之前要了解一下基本的部署流程,不要浪费时间,因为GPU很贵。

评论区